GPU와 HBM 어떻게 다른가

HBM 시장 성장 이제 시작

이 기사는 8월 26일 오후 3시18분 '해외 주식 투자의 도우미' GAM(Global Asset Management)에 출고된 프리미엄 기사입니다. GAM에서 회원 가입을 하면 9000여 해외 종목의 프리미엄 기사를 보실 수 있습니다.

[서울=뉴스핌] 황숙혜 기자 = 인공지능(AI) 투자 흐름에 변화가 두드러진다. 거대언어모델(LLM) 학습용 GPU(그래픽 처리장치)에 수요와 투자가 집중됐던 1차 트렌드에 이어 강력한 추론(inference)의 중요성이 크게 부각되는 2차 트렌드가 전개되는 모양새다.

실제 기업 실무에 동원되는 AI 소프트웨어가 본격적으로 공급되기 시작하면서 추론의 기능과 성능에 무게중심이 옮겨가는 상황이다.

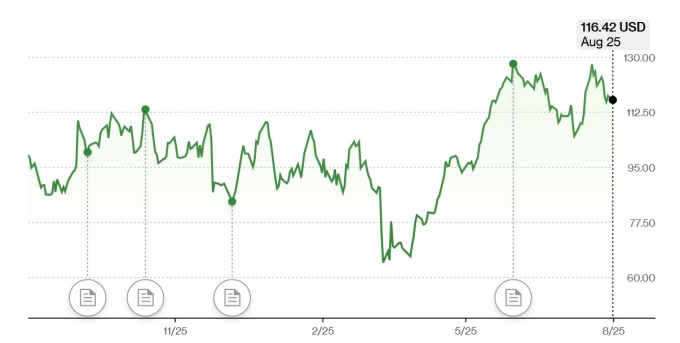

AI 투자의 판도 변화와 함께 주목 받는 종목이 마이크론 테크놀로지(MU)다. 추론 기능을 강화한 칩이 메모리 집약적인데 마이크론의 D램과 HBM(고대역록 메모리, High Bandwidth Memory)이 해당 워크로드 지원에 최적화 돼 있기 때문.

AI 칩 대장주로 꼽히는 엔비디아(NVDA)의 주력 상품은 GPU. 시장 전문가들은 고성능 메모리 반도체가 천문학적인 데이터로드를 감당해야 하는 지점에 이르면서 마이크론의 역할이 핵심으로 부상하고 있다고 말한다.

오픈AI를 주축으로 한 스타게이트를 포함한 대규모 프로젝트나 국가 AI 인프라 사업에서도 차세대 GPU와 네트워킹 장비, 고성능 메모리 및 스토리지가 뒷받침돼야 한다는 설명이다.

해당 시장이 추세적으로 확대되면서 마이크론이 안정적인 외형 성장을 보이는 한편 주가 역시 엔비디아와 동반 강세 흐름을 연출할 가능성에 무게가 실린다.

1978년 설립한 메모리 반도체 업체 마이크론은 D램과 낸드형 플래시를 기반으로 하는 메모리와 스토리지 제품을 주력 사업으로 한다.

여기에 HBM 솔루션을 앞세워 업체는 AI 인프라 투자 확대에 커다란 반사이익을 챙기는 모습이다. 엔비디아와 AMD(AMD)가 AI 모델을 학습시키는 데 핵심인 GPU를 설계하는 반면 마이크론은 HBM 솔루션을 제공해 GPU가 최적의 속도로 작동하도록 지원하는 한편 데이터 워크로드 처리 과정에서 발생하는 병목 현상을 줄여준다.

AI 모델의 훈련(training)과 추론(inference)은 목적과 과정, 필요한 리소스 등 여러 측면에서 구별되는 영역이다. 이를 바탕으로 GPU와 HBM, D램의 역할도 명확하게 구분된다.

훈련은 AI 모델, 즉 신경망이 대량의 데이터를 바탕으로 패턴을 학습하고, 가중치를 최적화하는 단계에 해당한다. 이 단계에서는 계산의 양이 방대하고 수많은 수학적 연산이 발생한다.

추론의 경우 학습된 모델을 사용해 처음 보는 새로운 데이터에 대한 예측과 분류, 결론을 도출하는 실제 서비스 단계라고 볼 수 있다. 일반적으로 단일 데이터나 소규모 데이터 입력에 대한 처리를 신속하게, 실시간으로 해낸다.

학교에서 수업을 받고 공부하는 단계가 훈련이라면 추론은 실제 시험장에서 문제를 푸는 과정이라고 볼 수 있다.

GPU는 AI 시대에 대규모 병렬 연산을 처리하는 '두뇌'에 해당한다. 특히 훈련 단계에서 필수적이다. GPU는 훈련과 추론 모두에서 사용되지만 훈련 과정에 더 큰 연산 능력이 요구된다.

HBM은 GPU와 더불어 대량의 데이터를 초고속으로 공급하는 메모리다. 데이터 전송의 병목 현상을 최소화해 GPU가 최대 성능을 발휘하도록 하고, 특히 대규모 모델의 훈련과 추론에 필수적이다. GPU가 무대의 주연이라면 HBM은 무대 뒤에서 공연을 가능하게 하는 데 핵심이라고 볼 수 있다.

일반 D램의 경우 컴퓨터와 서버 등에서 널리 사용되는 범용 메모리로, HBM에 비해 수평적인 구조를 취한다. 메인보드에 장착된다는 얘기다. 반면 속도와 대역폭, 에너지 효율 측면에서 HBM에 뒤쳐진다. 서버나 AI 환경에서는 HBM과 보완적으로 쓰인다.

AI 모델 훈련과 추론이 급증하면서 컴퓨팅 파워의 수요 역시 크게 늘어나고, 이는 결국 마이크론에 우호적인 여건을 제공한다.

AI 모델의 규모가 클수록 훈련과 추론에 필요한 연산량도 기하급수적으로 증가하는데, 이 때 데이터가 느리게 전달되면 병목 현상이 발생할 수 있다. HBM이 이를 해소해 AI 가속기의 효율을 극대화 한다. GPU의 성능만큼이나 HBM 역시 중요하다는 얘기다.

이른바 하이퍼스케일러(hyperscaler)라고 지칭되는 초대형 클라우드 기업이나 정부, 그 밖에 기업들의 대규모 AI 투자와 데이터센터 증설로 HBM 등 첨단 메모리 수요가 폭증하는 모양새다.

시장 전문가들은 HBM의 시장이 추세적인 성장을 나타내는 시나리오를 점친다. 블룸버그 인텔리전스 자료에 따르면 지난 2023년 40억달러로 파악된 전세계 HBM 시장이 2033년 1300억달러까지 성장할 전망이다. 연평균 42%에 달하는 고성장이 예고된 셈이다.

HBM은 D램의 한 종류이지만 설계와 제조, 성능 면에서 커다란 차이를 보인다. HBM은 여러 개의 D램 칩을 수직으로 쌓아 올린 3D 구조다. 메모리 층, 즉 스택(stack)이 많고 TSV(실리콘 관통 전극)를 통한 1024개 이상의 데이터 경로로 압도적인 대역폭을 제공한다. HBM3E의 경우 D램을 12층까지 쌓기도 한다.

일반 D램은 하나의 층으로 수평 배치하며, 데이터 통로도 32~64개 수준이다. 때문에 대역폭과 응답 속도가 HBM에 비해 낮다.

용도에서도 두 가지 칩이 다를 수밖에 없다. HBM이 AI와 슈퍼컴퓨터, 최신 GPU용으로 쓰이는 데 반해 일반 D램은 데스트탑과 노트북, 서버의 주요 메모리로 활용된다.

마이크론은 AI 인프라 투자가 확대될 때마다 실적과 시장 점유율의 동반 상승을 나타내고 있다. 시장 전문가들은 초기 HBM 시장을 삼성전자와 SK 하이닉스가 주도했지만 최근 마이크론의 점유율이 빠른 속도로 확대되고 있다고 말한다.

주요 외신에 따르면 2024년 기준 전세계 HBM 시장에서 마이크론의 점유율은 5.1%에 그쳤고, SK 하이닉스와 삼성전자가 각각 52.5%와 42.4%의 점유율을 차지했다. 하지만 2025년 마이크론의 점유율이 20~25%까지 치솟을 전망이다.

글로벌 HBM 시장에서 마이크론이 삼성전자와 SK 하이닉스의 양강 체제를 흔들고 있다는 얘기다. 업체의 가격 경쟁력과 미국 내 생산기지 및 공급망 확보가 배경으로 꼽힌다. 물리적인 입지가 미국 AI 및 클라우드 기업에 매력적이라는 진단이다.

여기에 HBM3와 HBM3E 등 마이크론이 최근 내놓은 차세대 제품의 성능과 수율이 크게 개선되면서 시장 입지가 한층 강화됐다는 분석이다.

HBM은 엔비디아와 AMD를 포함한 GPU 설계 업체들이 주력으로 사용하며, 구글과 마이크로소프트(MSFT), 아마존(AMZN), 메타 플랫폼스(META) 등 초대형 클라우드 업체들도 주요 고객들이다.

AI 데이터센터와 슈퍼컴퓨터, 첨단 국방 및 자동차, 로보틱스까지 다양한 섹터에서 HBM을 사용, 수요층이 날로 두터워지고 있다.

shhwang@newspim.com