모델 압축·최적화로 클라우드급 구현

온디바이스 전용 구조로 개인화·보안 강화

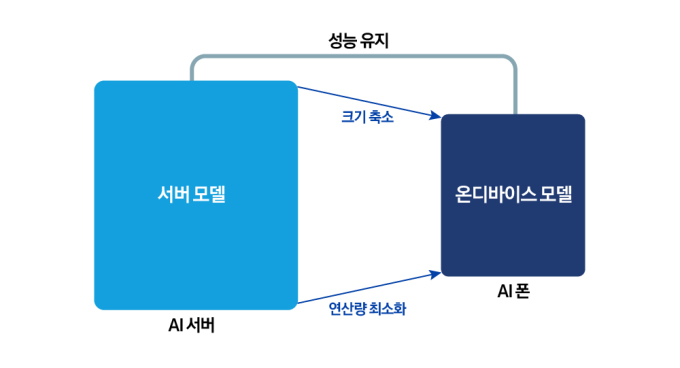

[서울=뉴스핌] 서영욱 기자 = 삼성전자가 온디바이스 인공지능(On-Device AI) 기술 고도화에 속도를 내고 있다. 초거대 AI 모델을 스마트폰·가전 등 기기 내부에서 직접 실행하는 방식으로, 속도와 보안, 개인화 성능을 모두 끌어올리는 전략이다.

삼성리서치 AI센터 함명주 마스터는 21일 삼성전자 뉴스룸 인터뷰에서 "핵심은 클라우드 수준의 AI 성능을 기기 안에서 구현하는 것"이라고 강조했다.

온디바이스 AI의 출발점은 거대언어모델(LLM)의 경량화다. 초고도 모델을 그대로 기기에서 실행할 경우 발열·배터리 소모·속도 저하가 불가피한 만큼, 모델 크기를 줄여야 한다.

함 마스터는 대표 기술로 '양자화(Quantization)'를 꼽았다. 기존 32비트 연산을 8비트·4비트 정수로 줄이는 방식이다. 그는 "고해상도 사진을 압축해도 화질이 크게 손상되지 않는 것과 유사하다"며 "정확도를 유지하면서 메모리와 연산량을 크게 줄일 수 있다"고 설명했다.

삼성리서치는 모델 가중치의 중요도에 따라 압축 강도를 달리하는 방식으로 정확도 손실을 최소화한 압축 알고리즘을 자체 개발해 모바일·가전 제품에 적용하고 있다.

모델을 얼마나 잘 압축하느냐보다 더 중요한 것은 기기 내부에서 어떻게 실행하느냐다. 삼성리서치는 CPU·GPU·NPU 등 연산 장치를 최적 배분하는 'AI 실행기(Execution Engine)'를 직접 개발하고 있다.

함 마스터는 "AI 실행기는 일종의 엔진 제어장치"라며 "연산량과 메모리 접근을 자동으로 조정해 기기 성능을 최대로 끌어올린다"고 했다.

삼성리서치는 이 기술을 통해 300억 파라미터 수준 모델도 3GB 이하 메모리에서 구동 가능한 수준의 효율을 확보했다.

이 과정에서 응답 속도는 빨라지고, 이미지 생성·대화 품질 등 모델 성능도 자연스럽게 개선된다.

AI의 기본 설계도인 아키텍처 연구도 병행되고 있다. 기존 트랜스포머(Transformer) 구조는 문맥 이해 능력은 뛰어나지만, 길이가 길어질수록 연산량이 기하급수적으로 늘어난다. 기기 환경에서는 비효율적이다.

함 마스터는 "온디바이스에 적합한 모델은 구조를 처음부터 다시 설계해야 한다"며 "하드웨어 효율을 극대화하는 새로운 아키텍처에 집중하고 있다"고 말했다.

삼성리서치는 학습 전 단계에서 하드웨어 자원 소모를 예측해 최적 구조를 설계하는 방식으로 학습 비용 절감과 효율성 향상을 동시에 노린다.

온디바이스 AI의 강점은 명확하다. 클라우드 연결 없이도 빠른 응답이 가능하고, 데이터가 기기 밖으로 나가지 않아 보안성이 높다. 사용자 환경에 맞춘 실시간 개인화도 강화된다.

함 마스터는 "앞으로는 속도·정확도·전력 효율의 동시 개선이 중요해질 것"이라며 "사용자 기기 안에서 AI가 스스로 학습하고 환경에 적응하는 수준까지 기술이 발전할 것"이라고 전망했다.

삼성전자는 모델 압축·실행 소프트웨어·신규 아키텍처 등 핵심 기술을 자체 개발해 온디바이스 AI 경쟁력을 끌어올리고 있다.

syu@newspim.com